|

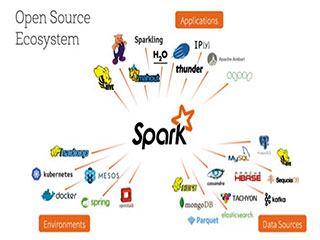

Для обеспечения надежности данных предприятиям требуется качественная транзакционная поддержка, и это особенно характерно для больших объемов данных. Ее отсутствие — одна из болевых точек, которая мешает предприятиям получить максимальную отдачу от своих озер данных (data lake). Как сообщает портал ZDNet, эту проблему взялась решить компания Databricks, основанная разработчиками платформы для обработки неструктурированных данных Apache Spark. Для обеспечения надежности данных предприятиям требуется качественная транзакционная поддержка, и это особенно характерно для больших объемов данных. Ее отсутствие — одна из болевых точек, которая мешает предприятиям получить максимальную отдачу от своих озер данных (data lake). Как сообщает портал ZDNet, эту проблему взялась решить компания Databricks, основанная разработчиками платформы для обработки неструктурированных данных Apache Spark.

В теории озеро данных выглядит как панацея от всех бед. Фактически оно представляет из себя единый репозиторий, который аккумулирует поступающие из множества источников данные, пригодные для дальнейшей обработки. Однако на практике все выглядит не так гладко: большинство предприятий накапливают данные бессистемно, превращая озера данных в болота. Databricks открыла код платформы Delta Lake с целью помочь предприятиям структурировать различные источники информации в озера с надежными и управляемыми данными.

Исторически так сложилось, что разработчики Hadoop не придавали слишком большого значения озерам данных. Первоначально Hadoop являлся онпремис-решением с файловой системой HDFS (Hadoop Distributed File System), которая предназначается для хранения больших кластеров данных. Выбор HDFS связан с тем, что она является экономически эффективным и надежным хранилищем данных всех форм и размеров, тогда как экосистема Hadoop предлагает множество вариантов обработки этих данных.

Тем не менее, со временем данные, а вместе с ними и озера данных, пережили эволюционные изменения. Основная идея состоит в том, что данные должны храниться в одном большом хранилище, но это не обязательно должно быть локальное хранилище, и не обязательно Hadoop. В современном виде Hadoop стремится стать базовой облачной технологией, и, соответственно, предложить технологию, которая бы позволила концентрировать информацию в едином облачном хранилище (озере данных).

Читать всю статью

Источник: Сергей Стельмах / itWeek

Фото: itWeek

Facebook

Мой мир

Вконтакте

Одноклассники

Google+

|

|

Для обеспечения надежности данных предприятиям требуется качественная транзакционная поддержка, и это особенно характерно для больших объемов данных. Ее отсутствие — одна из болевых точек, которая мешает предприятиям получить максимальную отдачу от своих озер данных (data lake). Как сообщает портал ZDNet, эту проблему взялась решить компания Databricks, основанная разработчиками платформы для обработки неструктурированных данных Apache Spark.

Для обеспечения надежности данных предприятиям требуется качественная транзакционная поддержка, и это особенно характерно для больших объемов данных. Ее отсутствие — одна из болевых точек, которая мешает предприятиям получить максимальную отдачу от своих озер данных (data lake). Как сообщает портал ZDNet, эту проблему взялась решить компания Databricks, основанная разработчиками платформы для обработки неструктурированных данных Apache Spark.